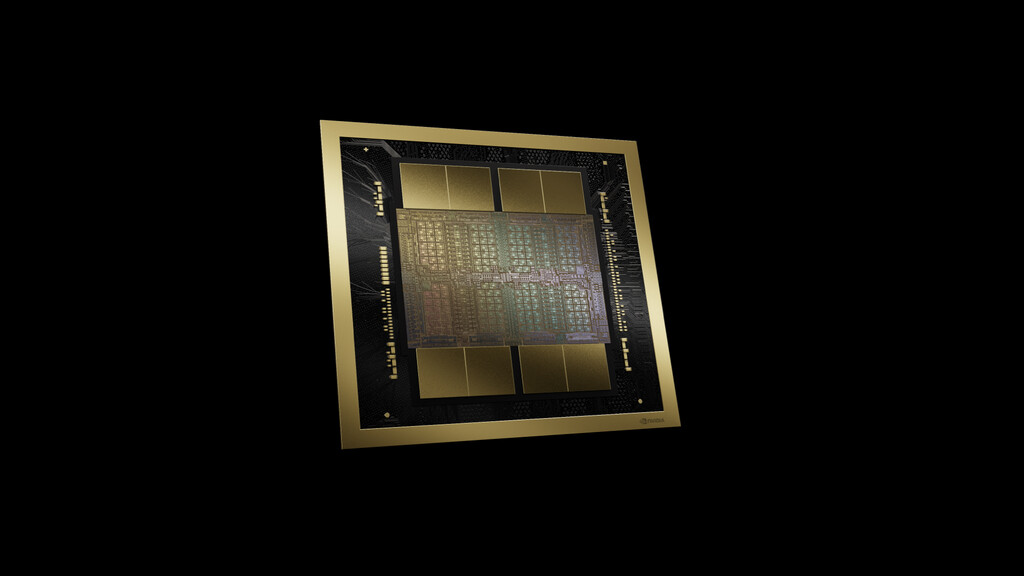

NVIDIA sabe muy bien cómo ponérselo difícil a la competencia: con su nuevo chip B200 con 208.000 millones de transistores

NVIDIA no está dispuesta a ceder terreno en el creciente mercado de la inteligencia artificial. Rivales como Cerebras y Rebellions empiezan a despuntar, pero la compañía liderada por Jensen Huang tiene una nueva propuesta para sus clientes más ambiciosos: acaba de presentar una nueva arquitectura de alto rendimiento denominada Blackwell que se materializa en dos nuevos chips, los B200 y GB200.

Los últimos años hemos sido testigos de la evolución de la compañía estadounidense. En 2020 presenciamos el lanzamiento de los chips A100, que llegaron con 54.000 millones de transistores, en 2022 llegaron los H100, aquella vez con 80.000 millones de transistores. Y ahora, con un H200 que todavía no está disponible, el fabricante acaba de anunciar el salto a los 208.000 millones de transistores.

B200, el nuevo chip de NVIDIA con una salvajada de transistores

En operaciones FP4, el nuevo chip B200 de NVIDIA promete ofrecer hasta 18 petaFLOPS de rendimiento en una configuración HGX o DGX refrigerada por aire. Sin embargo, aquellos clientes empresariales que deseen obtener un plus, podrán hacerlo si equipan a sus centros de datos con refrigeración líquida. Cumpliendo este requisito, el chip será capaz de alcanzar los 20 petaFLOPS de rendimiento.

A nivel de memoria, el B200 tiene un ancho de banda de 8 TB/s y admite hasta 192 GB de VRAM. Estamos frente a un chip de arquitectura Blackwell que, según su fabricante, puede reducir el consumo de energía hasta 25 veces en relación al H100. Cuando hablamos del chip H100, nos referimos al exitoso producto de arquitectura Hopper que se encuentra, por ejemplo, en los centros de datos de Azure AI de Microsoft.

DGX Superpod

DGX Superpod NVIDIA también ha anunciado el chip GB200. En este caso estamos ante una solución que combina una CPU Grace de 72 núcleos con dos GPU B200 para alcanzar un rendimiento teórico máximo de 40 petaFLOPS en operaciones FP4 y elevar la cantidad de memoria HBM3e hasta los 384 GB. La esencia de este “superchip” se sostiene gracias al sistema de interconexión de alta velocidad NVLink-C2C.

En pleno auge de la inteligencia artificial, este tipo de soluciones de hardware se ha vuelto elemental para entrenar modelos de lenguaje. Hoy tenemos a nuestra disposición modelos como GPT-4 de OpenAI o Claude 3 de Anthropic, que fueron entrenados con equipos menos potentes y menos eficientes. La nueva generación de hardware podría ayudar a acelerar los modelos que están en camino y que todavía no hemos visto.

Cuando se implementan las GPU en sus centros de datos se ubican en enormes racks. Una configuración DGX con 18 nodos GB200 puede trabajar con modelos de hasta 27 billones de parámetros. A nivel de rendimiento esto se traduce en más de 1 exaFLOP de rendimiento. Una auténtica locura si tenemos en cuenta que el primer sistema DGX que NVIDIA entregó a OpenAI alcanzaba un máximo de 0,17 petaFLOPS.

Imágenes | NVIDIA

En Xataka | Supermicro es el gigante oculto en la era de la IA. Está creciendo más que NVIDIA

(function() { window._JS_MODULES = window._JS_MODULES || {}; var headElement = document.getElementsByTagName(‘head’)[0]; if (_JS_MODULES.instagram) { var instagramScript = document.createElement(‘script’); instagramScript.src = ‘https://platform.instagram.com/en_US/embeds.js’; instagramScript.async = true; instagramScript.defer = true; headElement.appendChild(instagramScript); } })();

–

La noticia NVIDIA sabe muy bien cómo ponérselo difícil a la competencia: con su nuevo chip B200 con 208.000 millones de transistores fue publicada originalmente en Xataka por Javier Marquez .

Fuente: Xataka